视频点此

我其实多次提到过一种过时的信息流工具:RSS。这种信息聚合方法应该也有不少人听说过,但随着智能推荐算法的出现,RSS逐渐的走向没落,但它自身有些优势在如今也难寻替代:多平台聚合以及不被训练化。可能也正因如此,RSS才能在如今各式各样的信息流工具中仍能保留一席之地。那么今天,我想让这个老东西成为主角,来介绍一下我到现在还在使用的RSS源。

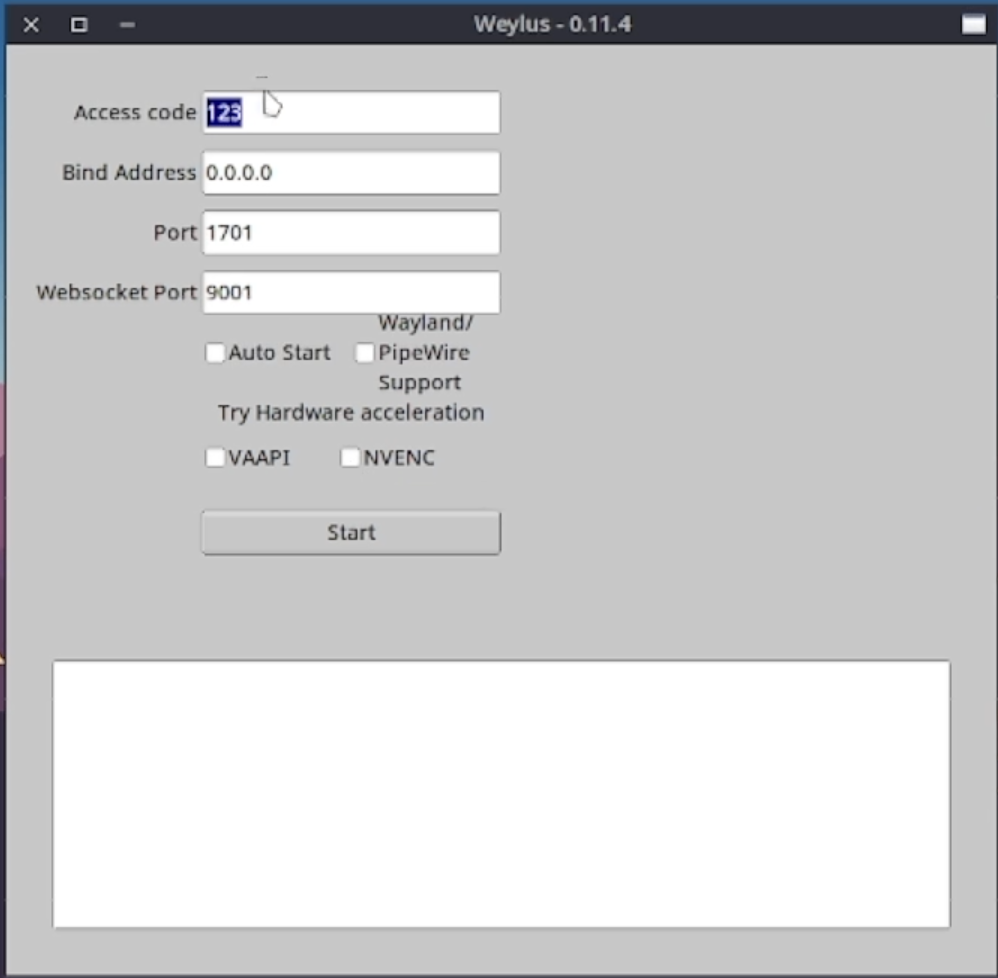

打开我的RSS订阅工具:

可以看到我把源简单的分成了几个组。这样一来,就可以从各种来源的文章中快速筛选特定主题的文章了。接下来,就从我订阅的27个源中,挑选一些我认为值得一看的源来简单介绍一下。

这是我现在知道的、Linux为主的、还在频繁更新的网站。每天都会有不少的内容更新。如果你想跟进一下人世间开源世界正在发生的故事,以及学习一些Linux的最新知识的话,可以来订阅一下这个网站。

如果你使用archlinux的话,那么我一定会推荐你订阅他们的消息发布站点。一个众所不周知的事实,由于archlinux的包管理比较粗犷,且滚动更新频繁,所以有可能会出现一些意想不到的问题需要用户手动干预。而这个站点正是官方提醒用户的一个消息发射站。即使你不用RSS,你也应该时常来这个网站看一看。不懂英语没关系,archlinuxcn提供了同样的服务供你使用。

这是RSSHub出现新的可订阅选项时提供订阅消息的RSS源,由RSSHub提供支持。如今还在使用RSS的人应该或多或少了解过这个工具。说白了,就是把所有没有RSS源的站点加上RSS功能。但世界上网站太多了,有一些网站可能要听到其他人推荐才能知晓。这个RSS源就给了你一个推荐的来源。

我非常喜欢看报纸,除了报纸那种纸质特有的声音和墨香,报纸上的语句会莫名其妙的让我沉浸下来。所以我订阅了人民日报的国际版块,我也推荐你着重浏览这个板块的内容。全球的偏实时新闻播报以及介绍当地风土人情或节日庆典的文章——注意哦,是真正的全球,并不是说国际板块不包括国内板块的内容,所以这也是为什么我更推荐使用国际板块的原因。相对于在这些新媒体上面的人民日报,这里的文章更有报纸的文风,读起来会更舒适。

本地最新咨询的提供源。使用下来,确实有不少东西是这个源提醒我的,比如马上就可以不预约退税了,比如地铁要甩站了,比如哪里有大型活动了,比如该查四六级成绩了…这个RSS源就是有RSSHub提供的,你可以自行选择你所在的城市来订阅。

我不是天文爱好者,但说到宇宙又确实有点感兴趣,但又不愿意去了解那么多枯燥的细枝末节。所以我订阅了这个源,时不常的提供一些天文事件、观测图片之类的,看看感觉也挺好的。

两个推荐软件的源。肯定不会说每一个都有用,但得空时候看一看,总会发现一些或者好玩儿,或者新鲜,或者可以提醒你这是你的一个痛点的软件,当然你甚至可以趁机白嫖一些还不错的东西,比如前阵子免费领取的Luminar4. 这是两个源,但内容基本都是软件推荐,所以总会有些重复。挑着看。

我没有针对某一个分类去订阅,所以我得到的更像是一个综合类RSS源,但又没那么发散,全都是围绕它的网站介绍:致力于更好地运用数字产品或科学方法,帮助用户提升工作效率和生活品质而产生的。我比较喜欢两个栏目:作者们都买了些啥、年度征文。可能年度征文不算一个有着明确主题的系列,但这些文章中提及的某一方面的处理思路总会有些借鉴意义,来优化我自己的工作流。

这也许是我所有订阅中内容最广、最杂的一个源。所以这个源的点击率可能是这些源中最低的,不过这并不影响我推荐它。虽然经常被说分享你刚编的故事,但精选板块还是有这一些科普意义所在的。如果你使用知乎app的话就会知道它的精选栏目中的文章质量,还是不错的。而这个源的内容便是完全复制自网站的精选栏目,值得一看。

其他的

还有一些其他的订阅,我觉得就不值得推荐给大家了,比如订阅了一些微博账号、一些up主频道、一些云主机的官网公告之类的,并没有那么大的普适性,这里就不介绍了。总而言之,RSS多平台聚合的能力不是让它消亡就能抹去的,加之RSSHub支持的订阅不断扩充,这种工具还能延续很长一段时间。

不过要注意的是,RSS阅读不会给来源站提供额外的点击量,所以RSS虽方便,但为了网站长久的运营,可以的话还是时常去源网站逛一逛,让这些明知只亏不赚却仍把RSS放在明面的网站得以生存的更久一些。